介绍

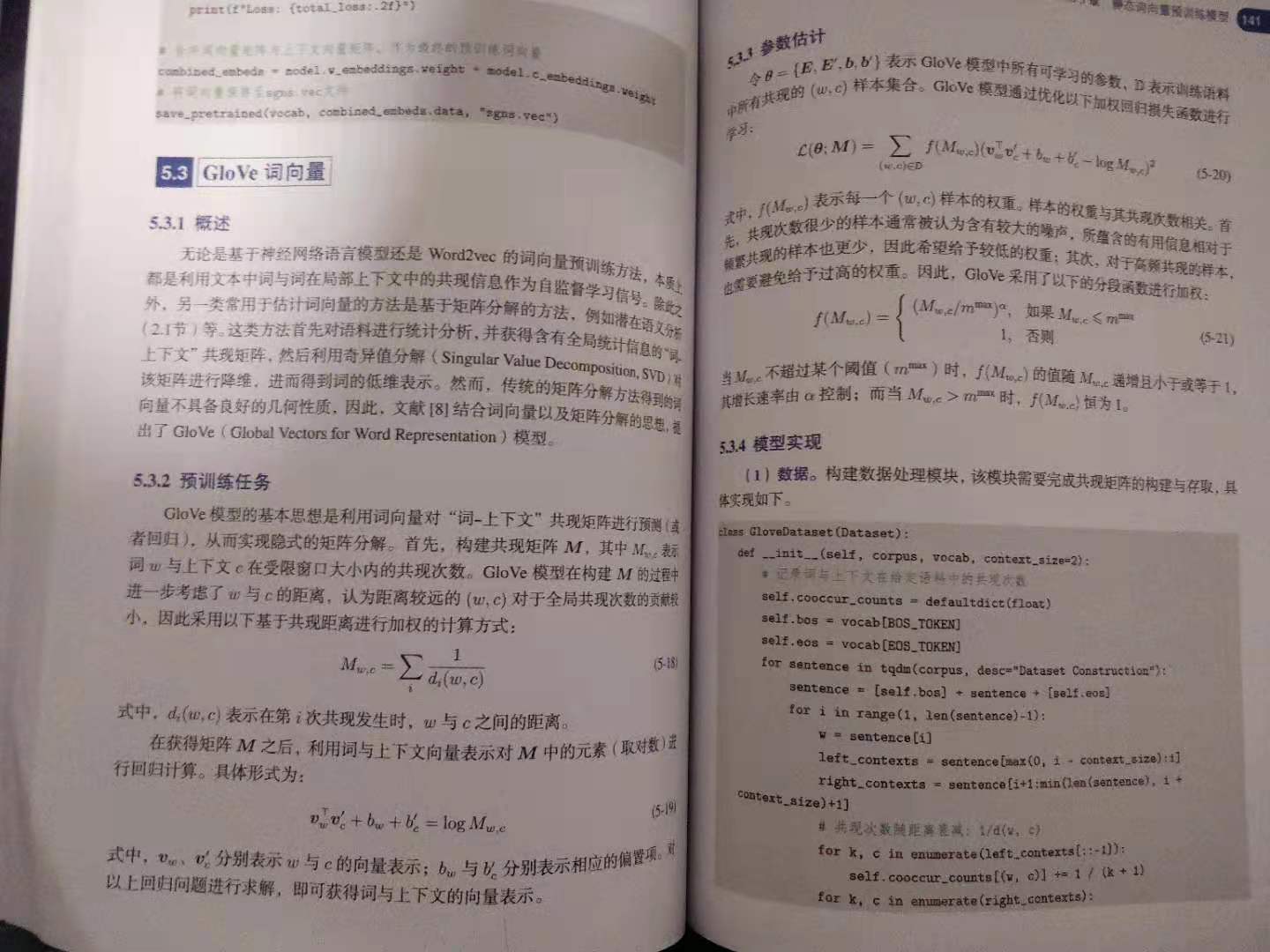

在之前讲解获取静态词向量的方法中,都是在context_size下用到了word和context的共现关系。要么word预测context words,要么context words预测word。本质上都是利用文本中词与词在局部上下文中的共现信息作为自监督学习信息。

还有一种是通过矩阵分解的方式,比如LSA,然后使用SVD进行奇异值分解,对该矩阵进行降维,获得词的低维表示。

这部分可以参考【词的分布式表示】点互信息PMI和基于SVD的潜在语义分析。

那glove的提出就是就是结合了这两者的特点。

实现

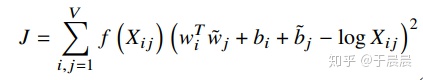

其loss函数如下所示:

嘿嘿,hexo貌似公式还要额外折腾,懒的搞了~

这个公式分成两部分:

- 获取样本权重,这个是根据context_size内的共现次数来确定的,但是加上了距离衰减。

- WiWj为词两者的向量,Bi和Bj分别代表各自的偏置,logXij表示共现。

1. 数据处理

同样加载reuters数据集,但是不同之处在Dataset那里。代码如下:

1 | # 非必要的忽略掉。 |

在共现次数随距离衰减那里,glove考虑了w与c的距离,即词w和上下文c在受限窗口大小内的共现次数与距离,越远的词的贡献程度越低。

下面在计算loss时有多个地方引用这个共现矩阵,所以注意。

2. 模型

1 | class GloveModel(nn.Module): |

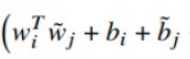

整体模型和其他求静态词向量的模型基本一致,只是多了求偏置部分。

3. 过程

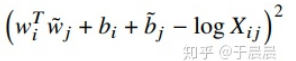

模型的输出就代表了下面这部分。

具体的实现代码如下所示。

1 | # 提取batch内词、上下文的向量表示及偏置 |

剩下log那项就是对共现矩阵求log。完整代码如下所示:

1 | words, contexts, counts = [x.to(device) for x in batch] |

剩下 这项,即是求样本权重,完整代码如下:

这项,即是求样本权重,完整代码如下:

1 | weight_factor = torch.clamp(torch.pow(counts / m_max, alpha), max=1.0) |

乍一看其实和求log(count)那部分没有本质区别。只不过是对其进行了分段加权处理。

本质是共现次数越少那么含有的有用信息越少,因此给予较低的权重,相反,对于高频出现的样本,那么也要避免给予过高的权重。

使用

关于静态词向量使用上可以有两个方向。一是计算词语之间的相似度(similar),二是根据一组词来类推相似的词(analogy)。

比如和哥哥相似的词是兄长,这个叫做相似度。

根据国王和皇后,来类推和男人相似的是女人。

总之这两者本质上来讲都是计算空间距离,具有相同语义的词的空间距离会更近。

完整测试代码如下:

1 | # Defined in Section 5.4.1 and 5.4.2 |

参考文档

完整实现

1 | # Defined in Section 5.3.4 |